Robots.txt является одним из самых важным файлов, когда вопрос заходит о продвижении сайта по поисковым запросам пользователей. О том, что из себя представляет данный файл и на что стоит обратить внимание при работе с ним, читайте в публикации.

Robots.txt - важно правильно настроить!

Robots.txt - это текстовый файл, который располагается в корневой папке сайта (в папке, где лежит весь сайт). Правильная настройка данного файла позволяет поисковой системе выдать пользователям нужные страницы и файлы.

Зачем используется файл

Информацию о сайте собирает робот поисковой системы. Когда он попадает на сайт, он считывает основные файлы, к которым относится и robots.txt. В данном файле он получает инструкции:

- что можно смотреть на сайте, а что нельзя;

- где искать специальные файлы;

- где расположена карта сайта.

После этого робот отправляет данные в поисковую систему, которая изучает сайт и определяет ему позицию в поиске. Поэтому данный файл имеет важнейшее значение и может как открыть страницы для робота, так и закрыть.

В каких случаях необходимо закрывать сайт от робота (индексации)

Чаще всего, сайт закрывают частично для предотвращения взлома. В основном закрывают папки с техническими файлами, которые организуют работу сайта (в том числе админ панели). Если случаи, когда необходимо закрыть сайт полностью. К примеру, если сайт копируется в другую директорию или домен для доработки. Тогда такой сайт необходимо закрыть от робота.

Что будет, если закрыть сайт от робота

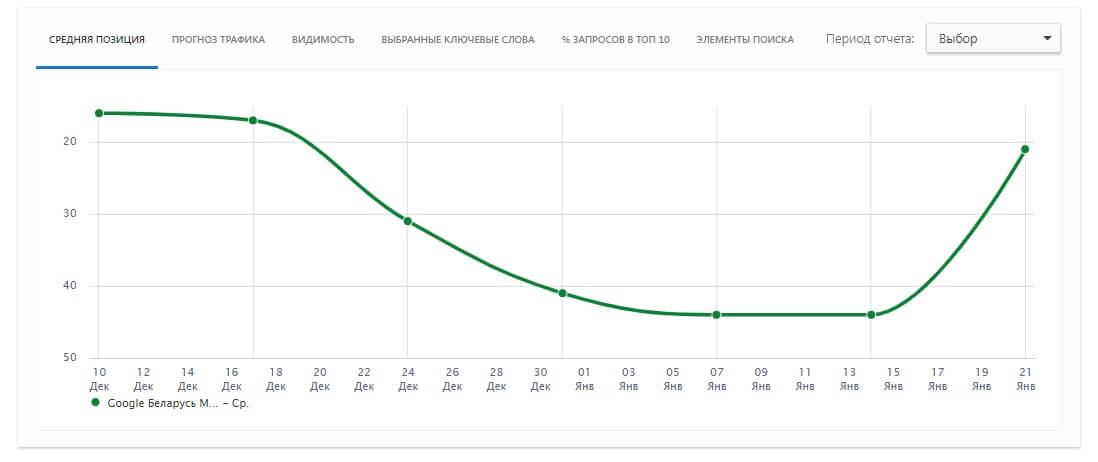

Бывают такие случае, когда ошибочно вводятся директивы в robots.txt либо сайт переносится после обновления с тестового домена на действующий. В случае, если имеется директива о запрете сайта к индексации, сайт начнет терять позиции. Поэтому важно держать файл в порядке и проверять его после обновления сайта.

Ниже представлена статистика по сайту, в котором был выставлен запрет для робота. Средняя позиция сайта в поисковой выдачи упала в течении 2 недель. Благо, такие ошибки можно исправить и вернуть сайт на прежние позиции.

Как определить блокировку сайта в файле robots.txt

Для этого понадобится блокнот или любой другой текстовый редактор. Необходимо зайти в основную папку, где находится сайт и найти там robots.txt. Далее проверить, есть ли в нем подобные директивы:

- Disallow: /

- Disallow: *

Если данные директивы отсутствуют, значит в robots.txt сайт не заблокирован. Также можно проверить корректность настройки с помощью специальной утилиты от Google или Яндекс. К ним можно получить доступ в панели вебмастера.

Если же такого файла нет вовсе, а сайт имеет несколько страниц либо подключен к системе управления сайта (CMS), рекомендуем его обязательно создать и настроить.

Если Вам необходима помощь в проверке и настройке robots.txt, можете обратиться в etiStudio.by.Мы также настраиваем sitemap.xml!